תוֹכֶן

- Big Data אינו מובנה או מובנה למחצה

- אין טעם לאחסן נתונים גדולים אם לא נוכל לעבד אותם

- כיצד Hadoop פותרת את בעיית הנתונים הגדולים

- התיק העסקי של Hadoop

להסיר:

Hadoop יכולה לעזור בפתרון כמה מאתגרים גדולים של נתונים גדולים.

נתונים גדולים זה ... טוב ... גדול בגודל! כמה נתונים ניתן לסווג כנתונים גדולים אינו קיצור ברור במיוחד, כך שלא ניתן להיקלע לדיון ההוא. עבור חברה קטנה שרגילה להתמודד עם נתונים בגיגה-בייט, 10 TB של נתונים יהיה גדול. עם זאת עבור חברות כמו ו- Yahoo, פטיט הוא גדול.בדיוק בגודל של נתונים גדולים, לא מאפשר (או לפחות אוסרת עלות) לאחסן אותם באחסון מסורתי כמו מסדי נתונים או קבצים רגילים. אנו מדברים על עלות לאחסון ג'יגה-בייט של נתונים. שימוש בתיקוני אחסון מסורתיים יכול לעלות הרבה כסף לאחסון נתונים גדולים.

כאן תסתכל על נתונים גדולים, אתגריה וכיצד Hadoop יכולה לעזור לפתור אותם.ראשית, אתגרים גדולים ביותר בנתונים גדולים.

Big Data אינו מובנה או מובנה למחצה

הרבה נתונים גדולים אינם מובנים. לדוגמה, נתוני יומן קליקים יכולים להיראות:חותמת זמן, user_id, עמוד, דף הפניה

היעדר מבנה גורם למאגרי נתונים יחסיים לא להתאים היטב לאחסון נתונים גדולים. בנוסף, לא הרבה מסדי נתונים יכולים להתמודד עם אחסון של מיליארדי שורות נתונים.

אין טעם לאחסן נתונים גדולים אם לא נוכל לעבד אותם

אחסון נתונים גדולים הוא חלק מהמשחק. עלינו לעבד אותו כדי לכרות את האינטליגנציה שלו. מערכות אחסון מסורתיות די "מטומטמות" במובן זה שהן פשוט מאחסנות ביטים. הם לא מציעים כל עיבוד כוח.במודל עיבוד הנתונים המסורתי יש נתונים המאוחסנים באשכול אחסון, המועתקים לאשכול מחשוב לעיבוד. התוצאות נכתבות בחזרה לאשכול האחסון.

מודל זה, לעומת זאת, לא עובד ממש עבור נתונים גדולים מכיוון שהעתקת כל כך הרבה נתונים לאשכול מחשוב עלולה להיות זמן רב מדי או בלתי אפשרי. אז מה היא התשובה?

פיתרון אחד הוא לעבד נתונים גדולים במקום, כמו למשל באשכול אחסון המשמש כאשכול מחשוב.

אז כפי שראינו לעיל, נתונים גדולים מתריסים עם אחסון מסורתי. אז איך מטפלים בנתונים גדולים?

כיצד Hadoop פותרת את בעיית הנתונים הגדולים

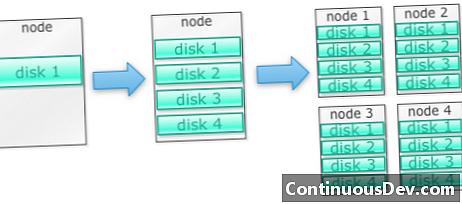

Hadoop בנויה לרוץ על מקבץ מכונותנתחיל בדוגמה. נניח שאנחנו צריכים לאחסן הרבה תמונות. נתחיל בדיסק יחיד. כאשר אנו חורגים מדיסק בודד, אנו עשויים להשתמש בכמה דיסקים המוערמים במחשב. כאשר אנו מוציאים את כל הדיסקים במכונה יחידה, אנו צריכים להשיג חבורה של מכונות, לכל אחת חבורה של דיסקים.

כך בדיוק בנויים Hadoop. Hadoop נועד לרוץ על מקבץ מכונות מההתחלה.

אשכולות Hadoop מתרחשים בצורה אופקית

יותר כוח אחסון וחישוב ניתן להשיג על ידי הוספת צמתים נוספים לאשכול Hadoop. זה מבטל את הצורך לקנות חומרה יותר ויותר חזקה ויקרה.

Hadoop יכולה לטפל בנתונים לא מובנים / מובנים למחצה

Hadoop לא אוכפת סכמה על הנתונים שהיא מאחסנת. זה יכול להתמודד עם נתונים שרירותיים ובינאריים. אז Hadoop יכולה לעכל כל נתונים לא מובנים בקלות.

אשכולות Hadoop מספקים אחסון ומחשוב

ראינו כיצד מקבצי אחסון ועיבוד נפרדים אינם המתאימים ביותר לנתונים גדולים. אשכולות Hadoop, עם זאת, מספקים אחסון ומחשוב מופץ הכל באחד.

התיק העסקי של Hadoop

Hadoop מספקת אחסון לנתונים גדולים במחיר סביר

אחסון נתונים גדולים באמצעות אחסון מסורתי יכול להיות יקר. Hadoop בנויה סביב חומרת סחורות, כך שהיא יכולה לספק אחסון גדול למדי בעלות סבירה. Hadoop שימש בשדה בקנה מידה פטיבה.

מחקר אחד של קלודרה העלה כי חברות בדרך כלל מוציאות בין 25,000 ל 50,000 $ לטרטה בשנה. עם Hadoop העלות הזו יורדת לכמה אלפי דולרים לטרטה בשנה. ככל שהחומרה הופכת זולה וזולה יותר, עלות זו ממשיכה לרדת.

Hadoop מאפשרת לכידת נתונים חדשים או יותר

לפעמים ארגונים לא לוכדים סוג של נתונים מכיוון שהיה עלול מדי לאסור לאחסן אותם. מכיוון שהאדופ מספק אחסון בעלות סבירה, ניתן ללכוד ולאחסן נתונים מסוג זה.

דוגמא אחת היא יומני קליקים באתר. מכיוון שהיקף היומנים הללו יכול להיות גבוה מאוד, לא הרבה ארגונים תפסו אותם. עכשיו עם Hadoop אפשר ללכוד ולאחסן את היומנים.

באמצעות Hadoop, אתה יכול לאחסן נתונים זמן רב יותר

כדי לנהל את נפח הנתונים המאוחסנים, חברות מנקות מעת לעת נתונים ישנים. לדוגמה, ניתן לאחסן רק יומנים בשלושת החודשים האחרונים, בעוד יומנים ישנים נמחקו. עם Hadoop אפשר לאחסן את הנתונים ההיסטוריים יותר. זה מאפשר לבצע ניתוחים חדשים על נתונים היסטוריים ישנים.

לדוגמה, קח יומני קליקים מאתר אינטרנט. לפני מספר שנים, יומנים אלה נשמרו במשך פרק זמן קצר כדי לחשב נתונים סטטיסטיים כמו דפים פופולריים. כעת עם Hadoop, קיימת אפשרות לאחסן את יומני הקליקים הללו לפרק זמן ארוך יותר.

Hadoop מספקת ניתוחים הניתנים להרחבה

אין טעם לאחסן את כל הנתונים האלה אם לא נוכל לנתח אותם. Hadoop מספקת לא רק אחסון מבוזר, אלא גם עיבוד מבוזר, מה שאומר שנוכל לרסק נפח גדול של נתונים במקביל. המסגרת המחשבתית של Hadoop נקראת MapReduce. MapReduce הוכח בסדר גודל של פטיט.

Hadoop מספקת ניתוחים עשירים

Native MapReduce תומך ב- Java כשפת תכנות ראשית. ניתן להשתמש גם בשפות אחרות כמו רובי, פייתון ו- R.

כמובן שכתיבת קוד MapReduce מותאם אישית אינה הדרך היחידה לנתח נתונים בהאדופ. הפחתת מפה ברמה גבוהה יותר זמינה. לדוגמה, כלי בשם Pig לוקח אנגלית כמו שפת זרימת נתונים ומתרגם אותם ל- MapReduce. כלי נוסף, Hive, לוקח שאילתות SQL ומריץ אותן באמצעות MapReduce.

כלי בינה עסקית (BI) יכולים לספק רמה גבוהה יותר של ניתוח. ישנם כלים לניתוח מסוג זה.

תוכן זה מוצג מתוך "Hadoop מואר" מאת מארק קרזנר וסוג'י מניאם. זה הועמד באמצעות רישיון Creative Commons ייחוס-לא מסחרי-שיתוף-דומה 3.0 ללא הובלה.